Índice de contenidos

Inst... Conceptos básicos

Imagen y sonido

¿Qué es el sonido?

Velocidad del sonido, Refracción, Reflexión, Interferencias

Tono, Timbre, Intensidad

Psicobiología de la percepción acústica

Reverberacion, Eco, Resonancia

Estéreo, Surround, Efecto Doppler

Zonas de percepción

Algún día, todo será digital

Proceso de conversión analógico-digital

Formatos

Surfeando en la onda

Conclusión y cierre

P-branas

Game Engine

Inst... Conceptos básicos

Imagen y sonido

La luz y el sonido tienen algo así como una relación de hermandad. La luz es, valga la redundancia, el hermano luminoso, el bonito, el que todo el mundo conoce y en el que todos se fijan. Quién más y quién menos ha oído hablar de fotones, conos y bastoncillos retinas, colores...

El sonido es el hermano malo, el del Lado Oscuro. Nadie se acuerda de él... excepto cuando falla. Porque, si la imagen es el físico, el sonido es, desde luego, el alma de lo audiovisual. Vamos a intentar darlo a conocer durante las próximas líneas.

¿Qué es el sonido?

Como “hermanos” que son, el sonido y la luz tienen muchas cosas en común, y otras particulares. Mientras que la luz es una onda electromagnética, capaz de propagarse en el vacío y excitar mediante fenómenos fotoquímicos los terminales nerviosos de nuestras retinas, el sonido es una onda de presión, que se propaga mediante procesos de compresión-descompresión del medio en el que se encuentra. Para hacerse una imagen mental, es algo parecido al típico juguete de movimiento continuo:

Por ello, en el vacío no se propaga al no haber nada (venga, va, quisquillosos: casi nada) que comprimir, y esto tiene dos graves consecuencias:

- Todas las películas de batallas espaciales son un gran embuste

- En el espacio, nadie puede oír tus gritos

Velocidad del sonido, Refracción, Reflexión, Interferencias

Sin embargo, comparte con la luz el que su velocidad cambie según el medio que atraviesa, y los fenómenos de refracción, reflexión e interferencias. En medios poco densos (por ejemplo, el caucho), su velocidad de transmisión será menor que en otros más densos (por ejemplo, el acero).

La velocidad de la luz (casi 300.000 Km/s en el vacío) es inmensamente más alta que la del sonido (340 m/s en el aire a 20ºC). Veremos aquello que provoca un sonido antes de escuchar el sonido que ha provocado. Primero vemos el relámpago y luego escuchamos el trueno. Esto tiene alguna implicación en la creación de animaciones, sobre todo en lo que respecta al lipsync o sincronización labial: si colocamos la voz del personaje a la vez que el movimiento labial, nuestro cerebro se quejará. Sin embargo, si lo desplazamos un par de frames más tarde, se verá (y escuchará) de forma mucho más natural.

El fenómeno de refracción es fácilmente perceptible cuando estamos buceando. Las voces que vienen de fuera (las que vienen de dentro son otro problema que ha de ser tratado con medicación) se escuchan distorsionadas por el cambio de velocidad y de dirección de la onda.

La reflexión, nos es mucho más familiar. Tiene mucho que ver con los coeficientes de absorción de los materiales, y vulgarmente lo conocemos como eco (más adelante entraremos en detalle sobre este aspecto). El reflejo no siempre es idéntico a la onda original; al igual que los objetos reflejan todas las frecuencias de la luz, excepto las que absorben (dando lugar a la percepción de los colores), también absorben más ciertas frecuencias de sonido, provocando efectos curiosos como el de la “carencia de eco” del pato, que en realidad no es más que el producto de la absorción de ciertas frecuencias, reflejando sólo una porción no audible para el oído humano.

A menos que seáis constructores de auditorios y teatros, o queráis buscar la localización idónea de vuestro flamante nuevo equipo de Home Cinema, no es necesario que os preocupéis de este asunto.

El sonido es una onda y, como tal, sufre fenómenos de interferencias. Los sonidos cuyas crestas están en la misma fase, incrementan su intensidad. Los que están en fases contrarias, se atenúan. El primer caso es muy importante de cara al audio digital, donde los sonidos fácilmente “saturan” el tope de sensibilidad de los micrófonos, provocando un resultado “cascado”. El segundo es interesante de cara a aplicaciones experimentales de reducción de ruido en lugares cercanos a sitios con alta contaminación acústica, ya que programas en tiempo real producen ondas complementarias que contribuyen a disminuir localmente dicho ruido, cancelando las fases del sonido. También se utiliza en la reducción de ruido en el post-procesado de audio.

Tono, Timbre, Intensidad

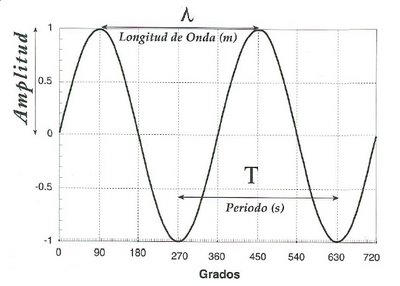

Hemos hablado de crestas de ondas. Veamos una imagen de una onda típica:

Una imagen está compuesta de diferentes colores con distinta saturación que dibujan formas. Una onda tiene una frecuencia fundamental (inversa a su longitud de onda), más o menos amplias y con unas determinadas frecuencias secundarias.

El tono es la altura del sonido. Cuanto menor sea su frecuencia (y por tanto, más amplia su longitud de onda), más grave será la nota. Al igual que en la luz sólo llegamos a captar frecuencias hasta un nivel de rojos (por encima de los infrarrojos), empezamos a captar sonidos a partir de los 20Hz (un herzio es un ciclo por segundo). Los tonos medios corresponden a frecuencias de unos 300 a 5000Hz (5KHz), y los agudos alcanzan hasta los 20KHz, que sería el límite de la audición humana (en la luz equivaldría al límite entre violeta y ultravioleta).

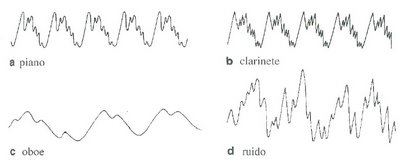

El timbre es la “forma” de la onda, sus frecuencias secundarias, y es lo que nuestro cerebro utiliza para distinguir la voz de Darth Vader de la de nuestra madre. Bueno, dependiendo de lo mucho que fume. O un piano, un violín o un oboe (por poner un ejemplo más clásico, suponiendo que estén tocando ese tipo de música) de una taladradora (según la pericia del practicante, la diferencia puede radicar en el sutil vibrato de la taladradora).

Podemos ver un ejemplo de las diferencias entre una nota de un piano, un violín, un oboe y un taladro en la Imagen 3:

También es muy importante la forma general de la onda (llamada envolvente), que también utiliza intensivamente nuestro cerebro para catalogar qué tipo de sonido estamos procesando (percusión, voz humana, instrumentos de viento...).

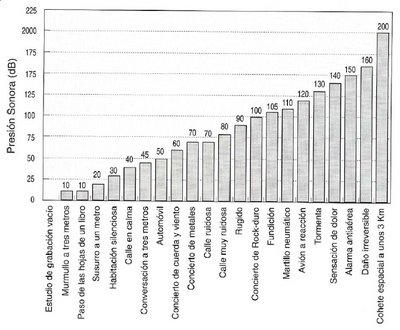

La intensidad de la onda tiene relación con la amplitud de dicha onda, y se traduce en el volumen con el que percibimos un sonido. Recordemos que el sonido es una onda de presión (y como tal, se podría medir en pascales). Sin embargo, el convenio general para medir el sonido es el de la relación de la intensidad del mismo con respecto a la intensidad de un ruido base, y su unidad son los deciBelios. Al igual que los terremotos, sigue una escala logarítmica, donde cada grado superior implica multiplicar la potencia. En la Imagen 5 podemos ver las distintas intensidades, en decibelios, de varias fuentes de sonido distintas.

Psicobiología de la percepción acústica

Reverberación, Eco, Resonancia

En realidad ya hemos empezado a hablar de percepciones, de lo que el cerebro interpreta o deja de interpretar. Sigamos, pues, con ello.

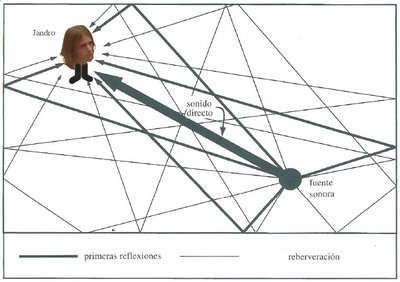

Antes hablábamos del fenómeno de la reflexión, y decíamos que se conocía como eco. En realidad, el eco no es más que una reflexión que tarda más de 50 milisegundos en llegar a nuestros oídos a partir de la fuente original. A menores tiempos, el cerebro no lo entiende como dos ondas diferentes, sino como una reverberación de la misma onda, una “cola residual” que, a efectos psicológicos, dota de calidez, profundidad e intensidad a un sonido (sólo hay que pensar en el estudiadísimo efecto de reverberación de las catedrales y los órganos, o en el leve eco que se suele dejar en las baladas). De la misma forma, la “iluminación global” o secundaria, proporciona mayor calidez y “organicidad” a las imágenes que hacen uso de ella, le da mucha más riqueza.

En el mundo sonoro, por tanto, hay que tener muy en cuenta cuál va a ser la reverberación final para conocer el impacto que un sonido tendrá sobre el público. Los estudios de grabación, las salas de cine, y por supuesto los auditorios y teatros han de estudiar a fondo los materiales y su disposición para incrementar o menguar los efectos de reverberación.

En la Imagen 6 podemos ver gráficamente cómo Jandro (¡el creador de YafRay, incultos!) recibe un haz de ondas sonoras.

La resonancia es la vibración “simpática” que se da en algunos objetos cuando la frecuencia fundamental de una onda que suena cerca es múltiplo (también llamado armónico) de su propia frecuencia de sonido. Por ejemplo, ciertas notas tocadas por instrumento de viento son capaces de hacer vibrar las cuerdas de una guitarra, si sus notas son las mismas o frecuencias múltiplos (octavas superiores). O las cuerdas del interior de un piano, cuando se toca una nota (ejercicio práctico: tocar fuerte una nota y, tras soltarla, pulsar el pedal de “sostenido” enseguida; las cuerdas, distensadas, vibrarán cada cual según su resonancia con la nota que hubiéramos pulsado). También nuestras cuerdas vocales tienen resonancia con nuestra propia voz, lo que produce frecuencias secundarias, armónicos, que le dan su timbre característico.

Estéreo, Surround, Efecto Doppler

Tenemos percepción de profundidad en la visión gracias a poseer un par de ojos (a menos que seas alguna especie de tipo raro con casco espacial y no distingas a tu suegra de un piano de cola). Esta estereoscopia permite a nuestro cerebro calcular la profundidad de un objeto a partir de las pequeñas diferencias de ángulo de la imagen recibida por cada ojo individual. Con los oídos pasa tres cuartos de lo mismo: dependiendo de su posición, una onda sonora llegará antes a un oído que a otro.

Si la fuente está más cerca de nuestro oído izquierdo, llegará antes hasta éste, atravesará el cráneo y estimulará más tarde el oído derecho.

Por la forma de nuestro pabellón auditivo, también escucharemos mejor los sonidos que provengan de nuestro frente que de nuestra espalda.

Con ambos factores, somos capaces de descubrir con bastante precisión la localización y lejanía de una fuente sonora a partir de las pequeñas diferencias de tiempo e intensidad.

Con una situación adecuada de fuentes sonoras, podemos conseguir un efecto envolvente (surround), sobre todo si contamos con un altavoz especial para bajos (subwoofer), ya que los altavoces convencionales apenas son capaces de reproducir ciertas frecuencias muy graves.

El efecto Doppler, al igual que se aplica a la luz para descubrir si un emisor se aleja -tiende al rojo- o se acerca -tiende al azul- al observador, muestra el mismo comportamiento en el sonido (al fin y al cabo, en ambos casos hablamos de frecuencias de ondas que se acercan o se alejan). Cuando un sonido se aleja, tiende a escucharse más grave (sus ondas nos llegan “alargadas”), mientras que si se acerca, se escucha más aguda (sus ondas nos llegan “comprimida”). Este efecto nos resulta muy familiar; todos reconocemos el sonido de una ambulancia acercándose y alejándose.

Zonas de percepción

Ni escuchamos las mismas frecuencias por igual, ni todos tenemos los mismos límites de audición. Las razones: milenios de evolución.

Como decía Jack, vayamos por partes. Literalmente.

En la Imagen 7, podemos ver el sistema auditivo con una serie de partes detalladas.

Recapitulemos: los sonidos son variaciones de presión que se transmiten por un medio no vacío. En el caso humano, este medio suele ser aire. Las ondas son recogidas y concentradas por el pabellón auditivo, que las conduce hasta el tímpano. El tímpano no es más que una membrana (como la de un tambor) que transmite esta vibración a los huesecillos del oído (martillo, yunque y estribo), que a su vez los transmite (ya con mucha menos fuerza) al oído interno (canales semicirculares y caracol). El oído interno se encarga, aparte del importante tema de escuchar, del no menos importante tema de conservar el equilibrio, estático o dinámico (también se encarga de averiguar si nos estamos moviendo). Una vez en el caracol, el sonido que ha sido transmitido por el estribo hace vibrar el líquido que lo contiene. Gracias a su forma en espiral estrechada, cada sección del caracol tiene resonancia con unas determinadas frecuencias. Desde los sonidos graves en la ancha base (a partir de 20 Hz) hasta los más agudos en la punta final (20 Khz). Los enlaces nerviosos de la zona se encargan de transducir la energía mecánica de la vibración a energía eléctrica, que mandan seguidamente a través del nervio auditivo.

Como podemos ver en la gráfica de respuesta a las frecuencias según la intensidad de la Imagen 8, tenemos un muy buen procesamiento de frecuencias medias (ya que es ahí donde se centran los sonidos que la Naturaleza considera más interesantes para nuestra supervivencia: un tigre rugiendo, una suegra acercándose...). No podemos escuchar ni las frecuencias muy bajas ni las muy altas, a menos que suenen a una determinada intensidad.

Si la intensidad es muy elevada, corremos el riesgo de romper la membrana timpánica, aunque podemos soportar mejor la intensidad en ciertas frecuencias, precisamente por la menor respuesta que tenemos ante las frecuencias graves y agudas.

Además de esto, la pérdida de audición por la edad también es diferente en hombres y mujeres, siendo mucho más acusada en los hombres. Algunos sugieren que es por escuchar continuadamente los gritos de dichas mujeres. Nunca lo sabremos con certeza.

Algún día, todo será digital

Proceso de conversión analógico-digital

Algún día, todo será digital. Por ahora, el audio ya lo es. Con las tecnologías de reducción de ruido como Dolby, la calidad del audio digital es, simplemente, perfecta.

La captura de sonido se realiza mediante micrófonos, que pueden ser de varios tipos según la direccionalidad del sonido que capturan (omnidireccionales, bidireccionales, unidireccionales o cardiodies...) o el método que utilizan para convertir el sonido de presión a electricidad (principalmente, dinámicos y de condensador). Las diferencias son principalmente de cantidad de sonido captado y de capacidad de soportar fuertes intensidades sin que el sonido “sature” y “se rompa”, lo cual suele ser inverso al rango de matices que son capaces de captar. Dicho de otra forma, las sutiles variaciones de potencial de la corriente eléctrica necesarias para recoger con gran precisión cierto tipo de sonidos, pueden provocar que, ante sonidos intensos, el voltaje se dispare al máximo, destrozando así la forma de onda y convirtiendo toda la información que llevaba ese sonido en un molesto ruido.

Cuando el sonido llega a la tarjeta de ídem, ésta muestrea la señal eléctrica X veces por segundo (frecuencia de muestreo), adjudicando a cada valor de entrada un determinado valor Y de salida dentro de un rango de bits (resolución). Dicho de otro modo, volviendo a las analogías con la imagen, la frecuencia de muestreo sería el tamaño en píxeles de la imagen, y la resolución sería la profundidad de colores de la misma. Cuanta más resolución, mayor número de grados intermedios de intensidad tendrá la onda. Cuanta mayor sea la frecuencia de muestreo, más muestras tendremos por segundo. En conjunto, la onda muestreada será más parecida a la analógica real cuanto mayores sean los valores mencionados.

Formatos

Después de esto, nuestra onda original se ha convertido en un chorro de números enteros (o incluso reales) en memoria, tantos como canales tuviera el sonido (un canal si es mono, dos si es estéreo, e incluso más para sonidos cuadrafónicos y surround). A la hora de guardar esta información en disco, tenemos dos opciones: guardarlas en formato bruto sin compresión (PCM, Pulse Code Modulation) o utilizar alguno de los formatos de compresión sin pérdida (FLAC) o con pérdida (más populares): MPG-1 Audio Layer 3 (mp3) o Vorbis-OGG (ogg). En contra de lo que normalmente se piensa, el conocido formato wav (WAVeform audio format) es sólo un formato “contenedor” (igual que el AVI para vídeo); el audio que lleve en su interior puede ir en bruto o comprimido con cualquiera de los métodos existentes.

En ambos formatos, mp3 y ogg, la compresión se centra en las frecuencias de la onda inaudibles para el oído humano (siguiendo un modelo psicoacústico), utilizando una tasa de bits variable (distinta cantidad de información por segundo, según lo que esté sonando).

Las diferencias:

Mp3 es un formato patentado por Thompson (por el que cobran importantes sumas en concepto de derechos de códecs en reproductores) y utiliza la Transformada Rápida de Fourier para codificar el sonido.

En cambio, ogg (formato libre) utiliza la Transformada de Cosenos Discreta Modificada y se espera que pronto pueda usar Wavelets, una forma mucho más sofisticada de codificación y análisis, basada en armónicos.

La combinación de alta calidad y formato libre del ogg está produciendo una debacle del formato mp3, si bien es lenta por la enorme extensión de uso del mp3 y el desconocimiento general de la existencia del ogg.

Surfeando en la onda

Una vez tenemos el audio en formato digital, podemos hacer mil virguerías con él utilizando un programa de retoque de audio como el programa libre Audacity http://audacity.sourceforge.org. Podemos cambiar la resolución y el muestreo de una onda, pasar de estéreo a mono y viceversa, cambiar el “panning” (la posición del sonido en el estéreo), agregar eco o reverberación, invertir los picos de la onda, invertir la onda al completo, reducir el ruido, acelerar o decelerar la reproducción, variar el tono, modificar su envolvente o su intensidad... Incluso este programa nos ofrece la posibilidad de dibujar la onda, ampliando muchísimo el zoom en ella.

También podemos generar sonidos digitalmente. Para ello tenemos dos opciones: la síntesis aditiva o la síntesis sustractiva. Al igual que en el color tenemos los mapas aditivos (RGB) y sustractivos (CMYK) según si sumamos luces al negro o restamos tintas al blanco, en el timbre podemos “añadirle al silencio” distintas frecuencias generadas mediante funciones sinusoidales o similares, o podemos restarle a una frecuencia dada una serie de frecuencias.

Conclusión y cierre

P-branas

Según la Wikipedia, la Teoría M es una de las candidatas a convertirse en la Teoría del Todo. Tiene su origen en la Teoría de las Cuerdas, según la cual todas las partículas son en realidad diminutas cuerdas que vibran a cierta frecuencia, y nosotros vivimos en un universo vibrando a cierta frecuencia.

No deja de ser poético el pensamiento de que, después de todo, nuestro Universo, con todo lo que contiene, es sólo una increíble sinfonía. Demasiado bonito como para dejar de lado algo tan cercano a esta realidad.

Game Engine

Blender tiene un Game Engine.

6 comentarios:

Ale, un "a veces pasan cosas" como el Monstruoso Spaguetti Volador manda. Forma parte de la charla de audio que di en la pasada Blendiberia 2006 (incluida en la Quijote Party 2006 de Ciudad Real, del 6 al 10 de este mes de Julio).

Fue estupenda. El año que viene "me toca" montarla a mí, en Castellón. Stay tunned...

ey, me ha encantado el artículo. Me embobo «leyéndote hablar» :)

Se agradece, aunque creo que te hubieran gustado más las "ocurrencias en vivo", jejeje.

Un saludete y ve cargando las pilas para la próxima iParty, que vamos a tener muuuucho trabajo ;) Mañana os comento en la reunión virtual (si no se me olvida que es miércoles, claro).

Hmmm... curioso, en la página principal dice que sólo hay dos comentarios, pero al pinchar sobre los comentarios hay tres. Bueno, ahora cuatro. Mi blogger no sabe contar.

A mí se me olvidó... ¡¡cuenta, cuenta!!

Yo utilizo a veces la técnica para conocer a alguna chica.

Publicar un comentario